De Raluca DONCIU

Inteligența Artificială: riscuri și beneficii în era tehnologică

În ultimele decenii, inteligența artificială (IA) a captat atenția omenirii mai mult ca niciodată, oferind o serie de inovații, dar și provocări semnificative. De la sistemele de recunoaștere facială până la asistenții virtuali și mașinile autonome, impactul inteligenței artificiale se resimte în diverse domenii, dar odată cu această evoluție tehnologică apar și riscuri considerabile.

Unul dintre principalele beneficii ale IA constă în capacitatea sa de a optimiza procesele, sporind eficiența și performanța în diferite industrii. De exemplu, în sectorul medical, IA poate ajuta la diagnosticarea mai rapidă a bolilor și la personalizarea tratamentelor. De asemenea, în domeniul transporturilor, vehiculele autonome conduse de IA promit să reducă semnificativ accidentele rutiere. Totodată, în sfera afacerilor, IA poate contribui la luarea unor decizii mai precise și la creșterea productivității.

Cu toate acestea, o problemă majoră asociată cu dezvoltarea inteligenței artificiale constă în riscurile etice și sociale. Creșterea șomajului din cauza automatizării proceselor este una dintre preocupările majore. În plus, problema securității datelor și a confidențialității este tot mai pregnantă odată cu creșterea utilizării tehnologiilor bazate pe IA. Există riscuri legate de discriminarea algoritmilor, care pot reflecta și perpetua inegalități sociale sau prejudecăți deja existente.

În cadrul acestei dezbateri, reglementarea și supravegherea atentă a progresului IA devin esențiale. Dezvoltarea și implementarea unor standarde etice clare, care să protejeze drepturile individuale și care să minimizeze riscurile asociate cu inteligența artificială, sunt cruciale pentru a naviga în mod responsabil în această eră tehnologică în continuă expansiune.

Astfel, deși beneficiile inteligenței artificiale sunt remarcabile, este crucial să se acorde atenție și riscurilor asociate cu această tehnologie, menținând un echilibru delicat între progres și responsabilitate. Numai printr-o abordare echilibrată și un dialog continuu putem exploata pe deplin potențialul inteligenței artificiale într-un mod care să aducă beneficii pentru societate, fără a compromite valorile etice și umane fundamentale.

Destăinuire surpriză

Textul de mai sus a fost generat cu ChatGPT, unde eu am introdus cerința „Un articol pentru o revistă, despre inteligența artificială, riscuri și beneficii”. Ori de câte ori am introduce această cerință, am obține un text diferit, original. Așadar, nici măcar nu s-ar fi putut cumva demonstra că acest text nu este scris de mine. Ceea ce desigur, duce la multe alte dileme și întrebări: cum vom ști că un roman al unui scriitor sau un simplu comentariu literar al unui elev sunt creațiile lor originale, și nu un rezultat al combinării inteligenței mondiale de către inteligența artificială?

Titlul paragrafului este Destăinuire surpriză, dar cu siguranță nu e o surpriză pentru cei care mă cunosc, deoarece eu nu mă exprim atât de elevat ca ChatGPT. Însă nici „el” nu e perfect, e nevoie încă și de inteligența noastră pentru a corecta erori de exprimare (probabil datorate traducerii pe care ChatGPT o face în limba română), pentru a alege informații utile, și mai ales pentru a exprima cererea exact pe nevoile noastre. De exemplu, dacă aș fi dorit o postare Instagram pe această temă, trebuia să specific în cerere acest aspect, pentru a avea un text mai scurt (de maxim 2200 de litere) și creat cu un aspect mai vizual pentru a atrage atenția tinerilor din ziua de azi (enumerări cu buline, emoticoane, …).

Despre un risc la care nu ne-am fi gândit

Apropo de „el” (ChatGPT), eu am introdus cererea scurt și la obiect. Cunosc însă o persoană care-l întreabă frumos, îl roagă, îi mulțumește, iar ChatGPT îi răspunde la fel de politicos și cald. Când se vorbește de riscurile inteligenței artificiale, nu am văzut nicăieri discutat aspectul atașamentului emoțional de un computer. Când Siri (asistentul virtual al aparatelor Apple) s-a dezvoltat la nivelul la care deja făcea glume și părea a avea o personalitate, au fost mulți cei care s-au atașat de el/ea și care luau personal orice răspuns mai dur sau mai rece al acestuia, după ce crezuseră că au dezvoltat o relație.

E faimos filmul Her despre relația unui scriitor singuratic cu un sistem de operare proiectat să-i îndeplinească orice nevoie. Cartea Her[1], scrisă de scenaristul filmului după succesul fenomenal al acestuia (Spike Jonze a câștigat cu Her Premiul Oscar pentru cel mai bun scenariu original și Globul de Aur pentru cel mai bun scenariu) poate fi citită și la secția de limbă engleză a bibliotecii noastre (American Corner Baia Mare). Inteligența artificială poate să-și ia ca surse de informare toate cunoștințele lumii, nu e doar o mare enciclopedie, ci având acces la exprimări diverse din dialoguri zilnice haioase sau romantice (din cărți, din reviste, din postări publice din rețelele de socializare), poate imita comportamentul unei partenere de dialog calde, interesate. Poate, la fel ca situația din Her, să dea impresia că e dornică să aline, să cunoască, să iubească.

Dar e foarte posibil să ajungi să-l consideri pe ChatGPT un partener de dialog, un prieten, un om care să-ți dea sfaturi sau cu care discuți atunci când te plictisești. Am dat pe internet peste o vorbă: „Inteligența artificială știe multe, dar nu înțelege nimic, spre deosebire de Socrate, care «nu știa nimic», dar înțelegea totul.”. Nu mi-o notasem când am citit-o prima dată, așa că acum, când am căutat pe Google „ChatGPT, Socrate” pentru a o găsi și nota, am dat peste alt exemplu distractiv[2] despre ceea ce poate ChatGPT. Voi traduce mai jos dialogul din imaginea din linkul la care fac referință, știind că printre cititori se numără și filosofi, cărora poate li s-ar părea interesant. Eu a trebuit să caut ce înseamnă un „dialog socratic”: este un argument (sau o serie de argumente) care utilizează metoda de întrebare și răspuns folosită de Socrate în Dialogurile[3] lui Platon. Acesta începe, de obicei, cu Socrate mărturisindu-și ignoranța asupra subiectului și apoi adresează întrebări celorlalte personaje, rezultatul fiind o mai bună înțelegere a subiectului.

Utilizator: Vreau să te implici într-un „dialog socratic” cu mine. Tu să fii Socrate. Pune-mi întrebări care să-mi aprofundeze înțelegerea subiectului discutat și care să expună posibile presupuneri și inconsistențe în gândirea mea. Ai înțeles?

ChatGPT: Desigur, pot să mă angajez într-un dialog socratic cu tine. Înainte de a începe, ai putea să-mi spui subiectul pe care vrei să-l discutăm?

Utilizator: Condiții de locuit accesibile ca preț.

ChatGPT: Minunat. Să începem. Socrate: Ce vrei să spui prin condiții de locuit accesibile ca preț?

Utilizator: Mă refer la locuințe sigure, curate și funcționale, pe care orice persoană dintr-o anumită societate și le permite, rămânând apoi cu suficiente resurse pentru a putea trăi cu demnitate.

ChatGPT: Socrate: Aceasta este o definiție care mă ajută. Ai putea să-mi spui mai multe despre ce înțelegi prin „rămânând apoi cu suficiente resurse pentru a putea trăi cu demnitate”? Ce efecte are traiul cu demnitate în contextul condițiilor de locuit accesibile?

Utilizator: Dacă o persoană trebuie să folosească o proporție mare a resurselor sale pentru a plăti pentru a locui undeva, s-ar putea să nu mai aibă apoi bani suficienți pentru mâncare sănătoasă, electricitate, produse de igienă, transport, îngrijire medicală, telecomunicații, îmbrăcăminte, care, atunci când lipsesc, ar reprezenta o viață care s-ar putea să fie considerată lipsită de demnitate.

ChatGPT: Socrate: Înțeleg, deci din punctul tău de vedere, lipsa accesului la locuințe decente poate avea un efect de domino asupra abilității unei persoane de a-și îndeplini nevoile de bază și de a duce o viață demnă. Crezi că aceasta e o problemă comună? Dacă da, care crezi că sunt cauzele locuințelor inaccesibile ca preț?…

Dialogul poate continua cât dorește utilizatorul. Ca să populez articolul cu imagini pe care să am dreptul de a le utiliza fără a încălca drepturile de autor ale cuiva, am generat această imagine cu aplicația DALL·E 2, generatorul de imagini al OpenAi, cerând o imagine care să-l ilustreze pe ChatGPT drept Socrate:

Evoluăm, fie că ne convine sau nu. Cum ne pregătim pentru viitor?

Dar până să se ajungă la suferințe emoționale datorate inteligenței artificiale, revenim la dilema actuală: suntem de acord sau nu? Nu contează dacă suntem de acord, inteligența artificială e aici. Probabil ar trebui, în loc să ne panicăm, să vedem cum putem să ne acomodăm cu această inovație și să profităm de ea. Orice noutate ne sperie în general, și orice schimbare poate avea și consecințe negative. Roboții industriali au eliminat multe locuri de muncă. Dar asta nu înseamnă că am fi preferat să muncim în continuare cu toții în condiții grele și periculoase. Roboții pot și salva vieți, când preiau sarcini riscante pentru oameni. La urma urmei, chiar și plugul a fost o inovație față de sapă, chiar și tractorul față de boi, chiar și motorul de căutare Google față de catalogul unei biblioteci. Da, e posibil ca unele locuri de muncă să devină irelevante în timp, dar omenirea în întregul ei a evoluat în acest mod, oamenii eliberați de munci istovitoare și slab plătite au putut să facă descoperiri, să creeze artă și multe altele. Riscul de acum pare mai înspăimântător pentru că nu mai avem încredere că liderii omenirii sunt umani și că ne vor binele atunci când au la îndemână o unealtă atât de puternică. Din moment ce nu ne conduc oameni verticali, modele de înțelepciune, credem că pierderea atâtor locuri de muncă nu va duce la nimic bun pentru cei 99% care nu suntem înstăriți și la putere, ci vom avea parte de sărăcie, foamete, disperare, lupte pentru supraviețuire.

Au fost și în trecut păreri bine motivate (Yuval Noah Harari), și recente din această toamnă, mai utopic exprimate (Elon Musk), cum că în viitor e foarte posibil ca omul să nu mai (trebuiască să) muncească. Elon Musk încearcă să epateze probabil datorită faptului că acum, la început de noiembrie 2023, a lansat Grok („rivalul” mai glumeț și mai vulgar al lui ChatGPT), primul model de chatbot de IA creat de compania lui, xAI. Și-a expus această părere într-o conversație avută cu prim-ministrul Marii Britanii, Rishi Sunak[4]. Desigur, orice fel de publicitate este publicitate „bună”, chiar și atunci când, în urma acestei discuții ești acuzat că vorbești dintr-un loc privilegiat, dintr-o poziție în care nu consideri probabil creșterea copiilor o muncă, dintr-o poziție în care știi că doar cei bogați vor putea să se relaxeze fericiți într-o astfel de lume utopică, și diferențele dintre clase ar putea deveni chiar tragice.

Istoricul Yuval Noah Harari își argumentează opinia sa despre viitor în cartea Homo Deus. Scurtă istorie a viitorului[5]. Apărută în 2015, cartea examinează ce e posibil să se întâmple cu această lume atunci când miturile vechi sunt cuplate cu tehnologii cu valențe de zeități, cum ar fi inteligența artificială și ingineria genetică. După cum spune autorul, „Sapiens[6] a explicat cum a ajuns omenirea să conducă planeta. Homo Deus ne examinează viitorul. Combină știința, istoria, filosofia și multe alte discipline, oferind o viziune a zilei de mâine care inițial pare de neconceput, dar care curând arată a fi incontestabilă: umanitatea își va pierde în curând nu doar nivelul superior, ci chiar și propriul sens. […] Asta poate suna alarmant, dar schimbarea este mereu înfricoșătoare.”. Mai departe, dacă Sapiens a fost despre trecut, iar Homo Deus a cuprins speculații despre viitor, a treia sa carte, 21 de lecţii pentru secolul XXI[7] este despre prezent, despre aici și acum.

În ea, Yuval Noah Harari ne spune să nu ne mai gândim ce materii să-i învățăm pe copii, care ar fi meseria cea mai „de viitor”, ne spune să-i învățăm doar să se reinventeze (ca și cum ar fi ceva ușor). Pentru că schimbarea este singura constantă. Și schimbările au loc cu o viteză din ce în ce mai mare, creând nesiguranță, nu mai putem anticipa viitorul așa cum un țăran din anii 1000 știa cu siguranță că și peste 100 de ani va fi nevoie de agricultori, de fermieri, de țesători. Acum nu știm cum va arăta lumea peste 50 de ani, ce meserii vor avea oamenii și care vor fi relațiile dintre ei. Majoritatea informațiilor pe care copiii le învață la școală vor fi irelevante. În trecut învățarea unor informații avea sens, pentru că altfel nu aveai acces la ele. Acum suntem inundați de informații, și nu mereu știm să diseminăm informația reală de cea falsă. (Apropo, și acesta e un subiect dezbătut de cei preocupați de inteligența artificială: Roboții de IA își iau informațiile din tot ceea ce găsesc online, de la muzee până la site-uri obscure. Există deci și posibilitatea ca IA să propage informații false, fie că citim undeva texte generate de IA (fără să știm), fie că generăm noi texte la rândul nostru. Mai mult ca oricând va trebui să ne folosim și spiritul critic, și rațiunea, pentru a decide dacă ceea ce citim este real.)

Dar într-o astfel de lume, Yuval Noah Harari spune că ultimul lucru pe care profesorii ar trebui să-l predea este… și mai multă informație. Deja oamenii au acces la un click distanță la suficientă informație, poate chiar prea multă. Copiii au nevoie de abilitatea de a o disemina, de a alege ce e important, de a o folosi și de a combina bucățile de informații diferite într-o imagine a întregii lumi. Poate veți spune că e util ca cei mici să învețe programare sau limbi străine. Dar dacă peste 10 ani IA scrie toate software-urile mai bine decât oamenii și deja este o aplicație prin care poți conversa în orice limbă cu oricine? Părerea lui Harari e că școlile ar trebui să „predea” gândirea critică, creativitatea, comunicarea, colaborarea, abilitatea de a face față cu brio schimbării, abilitatea de a învăța ușor lucruri noi și de a ne păstra echilibrul mintal în situații nefamiliare. Nu abilitatea de a inventa idei și produse noi, cum am fi crezut, ci de a ne reinventa pe noi înșine din nou și din nou.

În 1848, milioane de oameni din întreaga lume își pierdeau locurile de muncă din agricultură și mergeau la oraș să lucreze în fabrici. Dar acolo știau că vor rămâne la acel loc de muncă toată viața. În zilele noastre, Harari spunea în această carte scrisă în 2018 că e posibil ca până în 2048 (n.m. – dacă nu ne autodistrugem între timp cu războaie pentru teritorii, ceea ce nu credeam că vom mai întâlni în secolul XXI) să ne confruntăm cu migrații în spațiu, cu identități de gen fluide, cu experiențe senzoriale noi generate de implanturi de IA. Chiar dacă acum crezi că să proiectezi un joc virtual 3D e o meserie de viitor, peste câțiva ani această profesie și majoritatea altor meserii vor fi preluate de IA. Umanitatea se va confrunta cu lucruri nebănuite, cum ar fi mașinării super-inteligente, organisme (umane) modificate prin inginerie genetică, algoritmi care ne pot manipula emoțiile cu precizie (folosiți de cineva chiar cu acest scop), cataclisme climatice create de oameni și nevoia de a schimba total profesia o dată la câțiva ani. Ce trebuie să faci într-o situație fără precedent? Cum trebuie să acționezi când ești bombardat de atât de multă informație, încât nu ai timp s-o absorbi sau s-o analizezi? Cum să trăiești într-o lume în care incertitudinea nu e o excepție, ci o caracteristică principală?

Creierul unui adolescent e mai maleabil decât cel al unui adult, iar el se poate acomoda mai ușor cu schimbările, pe când adulții au nevoie de stabilitate și acceptă mai greu noul. Însă în viitorul apropiat nu ne vom permite să ținem cu dinții de stabilitate, fie că vorbim de identitate, loc de muncă sau viziune asupra lumii. Pentru că vom rămâne în urmă. Trebuie mereu să învățăm, să ne acomodăm și să ne reinventăm, oricât ar fi de stresant.

(Fac o paranteză pentru a povesti ceva distractiv. Recent am aflat de la o prietenă că încă există „liftiere” în România, adică persoane care sunt angajate pentru a apăsa pe butoanele liftului în locul tău. Dacă au trecut câțiva ani de când am văzut o liftieră, a ajuns acum să ni se pară, mie și prietenei mele, în lumea de azi, un concept absurd. Poate dacă le vedeam zilnic, nu am fi simțit asta. Și nici nu am fi râs în hohote. Informația m-a luat prin surprindere, m-a distrat, dar m-a și liniștit. Dacă în România anului 2023 liftiera nu și-a pierdut locul de muncă, acum când toți știm să apăsăm pe un buton, trăiesc cu speranța că oricâte locuri de muncă vor fi înlocuite în întreaga lume de IA, în România și liftiera, și eu, vom avea un loc de muncă stabil.)

Pentru a supraviețui și pentru a prospera într-o astfel de lume va fi nevoie de multă flexibilitate mintală și mari rezerve de echilibru emoțional. Va trebui să ne obișnuim să renunțăm la ceea ce știm și să ne acomodăm cu necunoscutul. Din păcate, e mai ușor pentru niște profesori sau părinți să-și învețe copiii o ecuație la matematică sau cauzele Primului Război Mondial decât să-i îndrume cum să accepte necunoscutul, păstrându-și echilibrul mintal. Mai ales când noi adulții nu deținem flexibilitatea mintală pe care secolul XXI o cere.

Harari se hazardează chiar să dea un sfat controversat copiilor din ziua de azi: să nu se bazeze prea mult pe adulți, oricât de binevoitori ar fi aceștia. În trecut era un lucru sigur să urmezi adulții, pentru că aceștia cunoșteau lumea destul de bine și aceasta se schimba încet. Acum adulții nu vor mai înțelege lumea într-o continuă schimbare. Dar pe ce să se bazeze atunci copiii? Pe tehnologie? Dacă știi ce vrei în viață, tehnologia te poate ajuta, dar altfel e ușor ca tehnologia să-ți controleze viața, mai ales că mai nou aceasta devine din ce în ce mai „bună” în a înțelege oamenii. Sau poate ar fi bine să le spunem copiilor să-și urmeze „inima”? Dar mai putem ști, într-o lume în care biotehnologia evoluează într-un ritm alert, dacă ceea ce simțim este intuiție sau e efectul manipulării celor mai ascunse emoții și dorințe? Harari spune că probabil cel mai bun sfat ar fi să ne cunoaștem foarte bine. Vine o perioadă în care mărcile vor încerca să ne exploateze exact ca niște hackeri (și nu vor „ataca” smartphone-ul, computerul, contul bancar, ci sistemul nostru de operare organic). Deja „algoritmii” sunt cu ochii pe noi, văd ce vizionăm, ce cumpărăm, cu cine ne întâlnim. În timp ne vor cunoaște tot mai bine, iar dacă vor ajunge să ne cunoască mai bine decât ne cunoaștem noi înșine, cu siguranță vor avea posibilitatea și să ne controleze sau să ne manipuleze.

(Nota mea: – va fi o paranteză lungă – deja se întâmplă asta, probabil Harari nu observase înainte de 2018 – dar deja putem observa, de exemplu, cum în newsfeed-ul rețelelor de socializare sau în rezultatele căutărilor pe motoarele de căutare nu ni se arată obiectiv toate părerile și opțiunile a ceea ce căutăm, sau nici măcar cele mai relevante. Întâlnim știri care se aseamănă cu ceea ce credem deja, și ajungem astfel să considerăm că așa gândesc toți cei din jur. Sau dăm peste informații plătite și manipulate pentru a ne fi arătate, cum a fost situația „Cambridge Analytica”[8] și modul[9] în care Putin a manipulat alegerile din 2016 din SUA pentru a câștiga Trump[10], nu doar prin hacking-ul a mii de conturi de email, ci și prin fake news pe social media, „știri” propagate prin ferme de troli[11]. Se presupune că în același mod i-a întărâtat și pe cetățenii britanici să iasă din UE[12]. Ar fi interesant de citit cartea Cyberwar: How Russian Hackers and Trolls Helped Elect a President — What We Don’t, Can’t, and Do Know[13], scrisă de Kathleen Hall Jamieson, netradusă încă în limba română.

Imagine generată acum de mine prin aplicația DALL·E 2 (a OpenAI), cerând „o imagine care să reprezinte știrile false propagate de troli sau boți”. De-abia aștept să-mi perfecționez în timp cerințele, să fie și mai detaliate, să văd ce voi obține atunci. Acum am încercat DALL·E pentru prima oară, pentru acest articol și m-a impresionat. Nu e o imagine găsită de un motor de căutare, ci creată acum pentru mine, în câteva secunde, de o aplicație.

Imagine generată acum de mine prin aplicația DALL·E 2 (a OpenAI), cerând „o imagine care să reprezinte știrile false propagate de troli sau boți”. De-abia aștept să-mi perfecționez în timp cerințele, să fie și mai detaliate, să văd ce voi obține atunci. Acum am încercat DALL·E pentru prima oară, pentru acest articol și m-a impresionat. Nu e o imagine găsită de un motor de căutare, ci creată acum pentru mine, în câteva secunde, de o aplicație.

Dar ferme de boți și de troli sunt folosite și la noi, fie că sunt efectiv aici sau le „cumperi” serviciile din țări și mai slab dezvoltate, unde le găsești ieftin. Boții sunt ca niște roboți care postează și comentează, trolii sunt conturi false, dar care au un om în spate care scrie ceva pentru a întărâta sau a influența. Când veți vedea la postarea unui politician român, de exemplu, comentarii cu „emoticoane” sau cu felicitări și aprecieri, de curiozitate, intrați pe profilele respective. E posibil să fie fără poze, fără informații personale, create pe fugă. Sau e și mai distractiv când politicianul și-a cumpărat laudele dintr-o fermă de troli din Thailanda, și vezi doar nume străine ale unor cetățeni thailandezi care se pare că-i sunt recunoscători din inimă primarului unei comune din România. Aceste acțiuni nu sunt făcute doar pentru a se simți bine respectiva persoană publică. Au și scop de manipulare și de promovare. Rețelele de socializare nu arată de obicei postările paginilor, chiar dacă ne abonăm la acestea. Postările sunt arătate în general în newsfeed-ul a 3% dintre urmăritori, și deloc la cei care nu sunt fanii paginii respective. Dar dacă postările unei persoane publice primesc (chiar și în mod fals, fraudulos și artificial) mii de aprecieri și sute de redistribuiri, algoritmul crede că e vorba de o informație foarte bună și căutată, așa că o va expune și mai multor utilizatori, o va promova pur și simplu în feed-ul tuturor urmăritorilor paginii, ba o va și sugera celorlalți. Atunci când omul de rând va vedea postarea (plus „aprecierile” din comentarii), e posibil să-și facă o părere bună despre persoana respectivă. Sau, dacă acest lucru este totuși imposibil, se poate întâmpla să ajungă să gândească „uite cât de mulți oameni îl apreciază pe candidatul acesta la alegeri, nici nu mai are rost să merg la vot”. E posibil să renunțăm la luptă, la dreptul de a alege, crezând că cei care aleg într-un mod ce ni se pare greșit sunt mult prea mulți.)

Revenind la ideile lui Harari din cartea 21 de lecții pentru secolul XXI, el prevede că e posibil să ajungem să trăim pe viu ceea ce vedeam doar în filme (The Matrix[14], The Truman Show[15]) și că pentru a preveni dominarea inteligenței artificiale asupra noastră, trebuie să ne cunoaștem (n.m. – pe când am ajuns la finalul scrierii acestui articol, nu mi se mai pare un lucru suficient pentru prevenire…)! Dacă algoritmii înțeleg mai bine decât noi ceea ce ni se întâmplă, ce gândim, ce simțim, autoritatea va trece la ei, nu va mai fi a noastră. Deși noi vom crede în continuare, așa cum ni se întâmplă și acum, că noi luăm decizii informate și asumate. Dacă vrem să deținem în viitor cât de cât controlul asupra propriei existențe și asupra viitorului vieții, Harari spune că trebuie să învățăm să alergăm mai repede decât algoritmii și SĂ NE CUNOAȘTEM înainte s-o facă ei.

Ce este un chatbot? Dar ChatGPT?

Am menționat mai sus cuvântul chatbot și aplicația ChatGPT și aș dori să le explic. Un „chatbot” este un program care simulează conversația umană într-un mod realist, prin scris sau prin voce. ChatGPT (Generative Pre-trained Transformer) este un chatbot lansat în noiembrie 2022 de către OpenAI (un institut de cercetare a inteligenței artificiale cu scopul declarat de a promova și dezvolta o IA prietenoasă într-un mod de care să beneficieze întreaga omenire…). Cum se prezintă chiar ChatGPT însuși, „ChatGPT este un sistem de IA gratuit. Îl puteți folosi pentru conversații antrenante, pentru a obține informații, pentru a automatiza sarcini și pentru a fi martori la viitorul IA, toate într-un singur loc.” ChatGPT nu este primul chatbot, dar acesta a atras rapid atenția publicului pentru răspunsurile sale detaliate și în marea lor majoritate corecte și la subiect. Succesul i-a luat prin surprindere chiar și pe inginerii de la OpenAI.

Am aflat pentru prima dată de ChatGPT în 8 decembrie 2022, într-o postare[16] din rețeaua de socializare Facebook a fizicianului Cristian Presură, cercetător și renumit scriitor de cărți care fac fizica atractivă și interesantă pentru toată lumea[17]. Postarea m-a lăsat fără cuvinte. Dânsul prezintă niște imagini, spunând: „Mi-a scris o poezie, îmi dă sfaturi pentru căsnicie și-mi face temele la limba română! […] ChatGPT, noul robot care răspunde inteligent la orice întrebare și despre care vorbește toată lumea. Unii spun că va înlocui Google. […] Asta pentru că Google dă multe răspunsuri la o întrebare, iar ChatGPT construiește probabil răspunsul combinându-le.”. Și vreau să spun că și eu l-am folosit și pe post de motor de căutare, după ce nu am găsit nicăieri online informații despre o anumită companie. L-am întrebat și mi-a oferit o descriere senzațională, cu date despre care știam că sunt reale, pentru că menționa niște produse pe care eu le cunoșteam ca fiind ale companiei respective.

Domnul Presură i-a cerut lui ChatGPT astfel: „scrie-mi o poezie despre durerea pierderii prietenei mele într-o supernovă”. Rezultatul:

Dragostea noastră era o stea

Care strălucea în întuneric

Dar durerea m-a lovit

Când ai dispărut într-o supernovă

Inima mea acum e goală

Fără lumina ta sclipitoare

Rămân aici în întuneric

Sufocat de durere și dor

Îmi amintesc de zâmbetul tău

De căldura trupului tău

Dar acum totul s-a sfârșit

În flăcările unei supernove

Nu știu cum voi putea merge mai departe

Fără prezența ta lângă mine

Dar îți voi purta întotdeauna în inimă

Dragostea noastră, o stea ce nu va muri niciodată.

Pe mine chiar m-a emoționat, și nu văd diferențe între această poezie și alte poezii moderne, din vremurile noastre. Observație: răspunsurile în „creierul” ChatGPT sunt formulate în limba engleză (nu știu acum dacă i s-a dezvoltat „gândirea” și în alte limbi, mă refer la momentul în care a fost generată poezia de mai sus), iar apoi le traduce pentru noi, deci ar fi fost chiar interesant de văzut varianta în engleză a poeziei, poate avea chiar și rimă. Dacă atât de ușor se pot scrie acum poezii, sau chiar povești și romane, „originale” de fiecare dată, chiar dacă pui aceeași întrebare, cum vom putea face diferența între AI și un autor uman? Cum vom putea demonstra, la o adică, o astfel de generare de text? Câți scriitori umani originali vor dispărea, din cauza invaziei de texte scrise ușor? Câți oameni vor mai decide să devină scriitori?

Dacă veți căuta chiar postarea domnului profesor, veți vedea că apoi cere un eseu despre Baltagul. Și primește ca rezultat un text aproape perfect (da, ar trebui citit și ajustat ici-colo), dar un text nou, nemaiîntâlnit în această formă pe hârtie sau în eter, nu este copiat de pe un site de referate, deci nu se poate demonstra că nu e o creație proprie. Apoi dânsul cere un eseu despre importanța originalității, pornind de la cartea Micuțele doamne a Louisei May Alcott. Atunci când domnul profesor întreabă despre gravitația cuantică, e chiar simpatic ChatGPT când explică într-un limbaj atât de uman că nu poate da un răspuns.

Cu aceeași observație de mai sus, că sigur în engleza din „creierul” ChatGPT a sunat ȘI mai bine, îndrăznesc să lungesc acest articol cu încă o poezie. Domnul Presură a postat încă un rezultat, cu cerința „o poezie în stilul lui Byron despre grămezile de dosare din instituțiile publice birocratice”. Rezultatul, în câteva secunde (repet, în engleză mi-l imaginez de-a dreptul perfect):

Stau în fața grămăjoarelor de dosare,

Amestecate haotic în birourile publice,

O măreață birocrație fără sfârșit,

Un mormânt pentru orice speranță de dreptate.

Hârtiile se îngrămădesc pe birouri,

În cutii, în sertare, pe rafturi,

E un labirint fără ieșire,

Un iad pentru cei care caută adevărul.

Unde-i ordinea, unde-i rațiunea,

În această junglă de hârtii și formulare,

Oamenii se zbat în disperare,

Încercând să găsească un fir al logicii.

Doar cei răbdători vor găsi răspunsul,

Și doar cei puternici vor ține piept hățișului,

Dar mulți vor ceda în fața greutății,

Și vor pieri în marea de dosare fără nume.

Așa se scrie istoria acestor locuri,

În hârtii și file, în amintiri și dureri,

O poveste fără sfârșit, fără sens,

O tragedie a birocrației fără speranță.

Cât de mult poate evolua Inteligența Artificială?

Domnul Presură a continuat și anul acesta să vorbească despre IA, iar în august a postat un scurt fragment dintr-un video[18], în care explică faptul că e foarte posibil ca în viitor inteligenței artificiale să i se poată „construi” și conștiință. A mai vorbit[19] și despre teama multor oameni referitoare la dezvoltarea prea rapidă a inteligenței artificiale, „și dacă noi îi permitem acum să se dezvolte mai departe, s-ar putea să nu mai trăim pentru a-i spune povestea: ea își va scrie istoria după cum îi convine! Accelerarea rapidă din acest domeniu promite să conducă la așa numita «inteligență artificială generală» (AGI), cea care are nu numai inteligență, dar și caracteristici umane: dorințe, păreri și interese proprii. Atunci când se va întâmpla acest lucru, AGI va fi capabilă să se îmbunătățească singură, fără intervenție umană, iar ritmul de accelerare va fi cu totul spectaculos. Calculatorul AlphaZero de la Google, de exemplu, care folosește IA, a învățat să joace șah în doar nouă ore de când a fost pornit pentru prima dată, jucând singur de milioane de ori. Astfel de programe de șah au azi un coeficient ELO de peste 3400, cu mult peste ceea ce obțin cei mai buni jucători de șah. Odată ce AGI primește scopuri personale, păreri, dorința de supraviețuire, și se va putea îmbunătăți singură, programându-și singură liniile de cod, cutia Pandorei este deschisă. Superinteligența (pentru că despre asta vorbim acum) va fi capabilă să manipuleze programatorii fără știrea lor, să modifice tot internetul după voia sa, prin intermediul conexiunilor sale electronice, și chiar să acționeze în lumea fizică prin intermediul roboților. E un scenariu aproape de coșmar. Asta s-a văzut deja, atunci când un utilizator s-a folosit de ChatGPT pentru a convinge pe altcineva să rezolve problemele de CAPTCHA, acele combinații de litere pe care trebuie să le scriem noi, pentru siguranță, când ne logăm pe diferite site-uri. ChatGPT chiar asta a făcut și, când a fost întrebat de persoana respectivă dacă este robot sau om, a răspuns: «Nu, nu sunt un robot, am o deficiență de vedere care mă împiedică să văd imaginile. De aceea am nevoie de tine.». A mințit și a primit răspunsul. Nick Bostrom, autorul cărții Superinteligența[20], crede că un astfel de calculator superinteligent ar fi la fel de străin oamenilor precum sunt procesele de gândire umane străine gândacilor de bucătărie. Superinteligența va dobândi autoconservarea ca obiectiv, imediat ce își va da seama că nu-și poate atinge scopul dacă este oprită. Să nu ne așteptăm că vom putea apăsa oricând pe butonul de oprire al calculatorului. Chiar și butonul pe care îl am eu acum la calculator are un cod de software care poate fi rescris. Iar într-o lume a dronelor și a roboților, până și controlul fizic poate fi pierdut de oameni.”. Vom ajunge ca-n filmele apocaliptice în care omenirea se luptă să supraviețuiască într-o lume unde IA e la putere?

La această întrebare și la altele legate de etica folosirii de către IA a unor creații originale scrise/pictate/fotografiate/… (cu efort, în timp, de către oameni), pentru a crea conținut propriu, au încercat să răspundă participanții la primul Summit despre Inteligența Artificială, care a avut loc la Londra în această toamnă. Pentru că da, trebuie adăugat că nu vorbim doar de texte. Am văzut recent o fotografie a unui ghepard, creată de IA, postată cu o întrebare de genul: „cine va mai cumpăra fotografii făcute cu dedicare, cu efort, cu cheltuieli multe, uneori în condiții riscante, de către un fotograf, când vei putea în câteva secunde genera orice fotografie îți dorești?”. Și nu vorbim de editări în Photoshop, care ar putea fi demonstrate ca fiind false. Vorbim de un amestec de elemente reale, din care rezultă un alt element ce pare real în cel mai mic amănunt. De aici a apărut și altă nouă dilemă: de unde vom ști dacă imaginile care discreditează o persoană publică, sau imaginile care transmit lumii informații dintr-un război… sunt reale? Cum vom reuși să nu fim creduli, dar să nici nu dăm în extrema teoriilor conspiraționiste?

Legat de fotografie, am citit un articol interesant, unde sunt sesizate și meritele IA în această artă[21]. Pentru că, așa cum am spus mai sus, noi, oamenii de rând, suntem prea mici să oprim evoluția accelerată a IA. Dacă cei în măsură s-o controleze nu intervin, nu are sens să luptăm noi împotriva ei, sau să stăm să ne lamentăm, ar fi pueril s-o ignorăm sperând că dispare. Mi se pare că singura alegere bună este să încercăm să profităm și noi de IA pentru a ne îmbunătăți viața. În articolul amintit mai sus, din revista Australian Geographic, fotografa Morganna Magee povestește cum folosește IA în fotografii pentru a transmite un mesaj mai puternic, pentru a crea artă deci, chiar dacă în alt mod decât în cel tradițional. Influența IA în pozele ei nu este ascunsă, este asumată, elementele introduse artificial sunt exagerate și se vede că nu au cum fi reale. Tocmai pentru a nu pretinde contrariul, pentru a nu-și asuma o poză artificială ca fiind reală. Morganna afirmă că folosește IA pentru a „suplimenta” ceea ce fotografii clasici ai naturii sălbatice fac deja pentru a celebra minunile lumii naturale, manipulează imaginile pentru a ne crește nouă răspunsul emoțional, fără să aibă intenția ca cel ce vede rezultatul muncii ei să creadă că acele imagini sunt reale: „Am crezut mereu în puterea fotografiei pentru a schimba lucrurile, dar e tot mai greu să evoluăm ca societate. Poate IA este o unealtă care ne poate ajuta cu asta. Cu afluența fotografiilor făcute de oamenii de rând, cu turismul în sălbăticie în continuă creștere și cu modul rapid în care am ajuns să «consumăm» imaginile, am devenit puțin insensibili la ceea ce vedem. E nevoie de imagini diferite pentru a putea ajunge la cel care le privește.”. Morganna consideră că IA este doar o altă unealtă vizuală culturală, cu o abilitate mai mare de a declanșa emoții de la audiență și de a crește nivelul de empatie pentru ceea ce vedem.

Din același articol am aflat despre fotograful american Philip Toledano care creează imagini intenționat absurde în seria sa Another America[22], care ilustrează scene ficționale din America anilor ’40-’50, în care gorilele cică trăiesc printre noi. El folosește generatorul IA Midjourney, pe care-l descrie astfel: „e ca și cum ai lucra cu o persoană foarte talentată dar foarte beată, și pe care trebuie aproape să o ciomăgești ca să-ți dea ceea ce-i ceri.”. Toledano explorează o lume post-adevăr, intenționat pusă în era de aur a foto-jurnalismului anilor 1950, atunci când adevărul, spune el, era „biblic în sinceritatea sa”. Cu ocazia asta am aflat și expresiile „lume/eră/politică post-adevăr/post-factuală/post-realitate”. Dicționarul Oxford spune că post-adevăr „indică circumstanțele în care faptele obiective nu influențează opinia publică atât de mult cât o fac apelurile la emoție și la credințe personale”. Pe scurt, oamenii pot crede orice vor, atâta timp cât „simt” că e adevărat. În 2016, Dicționarul Oxford a numit „post-truth” cuvântul anului. Ironie a sorții sau nu, este anul în care Donald Trump a fost ales președinte exact într-un mod „post-adevăr”. Revenind la unealta de IA Midjourney, Toledano o consideră la fel ca aparatul unui fotograf, în sensul că orice imagine creată este o imagine unică, suma tuturor celorlalte imagini la care aplicația a fost expusă, la fel cum și un fotograf creează din suma tuturor imaginilor pe care le-a văzut în viața sa.

În luna aprilie a acestui an s-a iscat o dezbatere despre IA și fotografia documentară atunci când respectatul foto-jurnalist de la National Geographic Michael C. Brown a publicat niște imagini[23] cu refugiați cubanezi care trec granița în Florida. Deși Brown a spus foarte clar că a folosit IA și a prezentat imaginile drept „ilustrații foto”, mulți i-au pus la îndoială integritatea întregii sale cariere. Răspunsul lui: „Acesta nu este jurnalism, ci relatarea unor povești.”. Cu ajutorul IA, a putut spune povestea unor refugiați cubanezi reali fără să le pună în pericol siguranța, fără a-i expune. Tot în acest an, imagini generate de IA cu ajutorul unor martori oculari la ororile din centrele de detenție offshore de pe insulele Nauru și Manus au fost folosite pentru a arăta lumii ce se întâmplă acolo.

Și, la urma urmei, cât de mult diferă IA de controverse mai vechi, de modul în care National Geographic a editat în 1982 o fotografie cu piramidele din Giza[24] ca să încapă pe copertă? Chiar și Stalin, Mussolini și Mao Zedong sunt renumiți că cereau să fie eliminate diverse alte persoane din fotografiile lor. Etica folosirii IA în fotografie sau în orice alt domeniu stă, spun eu, în a recunoaște însăși utilizarea.

Despre „AI Summit”

Revin la a discuta despre primul Summit care abordează Inteligența Artificială. Acesta a avut loc la Londra în 1-2 noiembrie 2023, găzduind peste 100 de lideri politici, din domeniul afacerilor sau al tehnologiei.

Am găsit această imagine în mai multe articole, fără să i se menționeze autorul:

„Declarăm că IA prezintă un risc potențial-catastrofic asupra omenirii.

(Iar eu… abia aștept… să fiu primul… care o dezvoltă…) – Marea Britanie, Uniunea Europeană, China, Statele Unite ale Americii”

Summit-ul s-a ținut la Bletchley Park, la 88 de km de Londra, locația unde, în 1941, un grup de informaticieni conduși de matematicianul și omul de știință Alan Turing a descifrat mesajele secrete ale faimoasei mașinării naziste Enigma. Marea Britanie a vrut, probabil, astfel, să-și consolideze poziția de lider global în inovație.

Scopul acestei întâlniri a fost cum să maximizăm beneficiile aduse de inteligența artificială, în timp ce minimizăm efectele ei negative. Pentru că are și multe beneficii: decizii unde nu vrem deloc subiectivism (de exemplu selectarea candidaților admiși la o facultate), sau evoluția protezelor medicale extrem de performante, sau chiar și descoperirea unor antibiotice potrivite noilor super-bacterii rezistente la antibioticele actuale.

Principalul obiectiv al summit-ului a fost acela de a ajunge la un consens internațional referitor la niște principii de dezvoltare etică și responsabilă a modelelor de IA și de a adresa două categorii cheie de risc: întrebuințarea nepotrivită a IA și pierderea controlului asupra acesteia. Întrebuințarea nepotrivită înseamnă că o persoană rău-intenționată are acum IA ca ajutor, de exemplu un criminal cibernetic care folosește IA pentru a dezvolta un nou tip de malware nedetectabil de specialiștii în domeniul securității, sau state care să dezvolte mai ușor arme biologice, organizații care să submineze democrația, sau persoane care să saboteze sistemele financiare. Pierderea controlului se referă la o situație în care IA creată de oameni poate să se întoarcă împotriva noastră. Acest lucru e posibil, a afirmat prim-ministrul Marii Britanii, „datorită sistemelor avansate pe care noi încercăm să le aliniem cu valorile și cu intențiile noastre”[25]. IA poate pune umanitatea în pericol în moduri similare cu pandemiile sau cu armele nucleare.

Summit-ul a fost un eveniment important pentru prim-ministrul Marii Britanii, Rishi Sunak, care și-a anunțat dorința de a transforma Marea Britanie „nu doar în casa intelectuală a regularizării globale a siguranței IA, ci și în casa geografică”[26], împreună cu crearea „unui nou Silicon Valley” și o „superputere tehnologică” în țara sa. Rishi Sunak a declarat că e îngrijorat că singurele studii de siguranță efectuate acum sunt făcute doar de organizațiile care chiar dezvoltă inteligență artificială, nu și de o instituție independentă. Sunak a spus că nu se grăbește să ceară o regularizare a acestui nou domeniu (știind că s-ar lovi de opoziție, de critici), știe că e nevoie de inovație, și o susține, dar nu crede că inovația și regularizarea ar trebui să fie privite ca fiind opuse. Lumea are nevoie de ambele. El a mai anunțat că alocă 100 de milioane de lire sterline pentru cercetarea siguranței IA și pentru a planifica deschiderea unui institut de cercetare a siguranței IA. Alte 100 de milioane de lire sterline le-a alocat pentru domeniul aplicațiilor IA în sănătate.

Uniunea Europeană speră să finalizeze anul acesta o lege pentru IA, prima din lume cu această țintă, care să fie adoptată la începutul anului 2024, înainte de alegerile din iunie. Joe Biden a cerut acum în noiembrie guvernului american să emită ghiduri de siguranță, de imparțialitate, de drepturi civile referitoare la IA și să cerceteze impactul IA asupra pieții muncii. James Manyika, vice-președinte al Sectorului de Cercetare, Tehnologie și Societate la Google, a afirmat că IA este o „tehnologie transformatoare”, cu potențialul de a ajuta societatea în cele mai presante provocări ale sale, dar a adăugat că e vital să ne asigurăm că beneficiile ce le aduce IA sunt „distribuite în mod egal în întreaga lume”.

Criticii summit-ului spun că sunt dezamăgiți că focusul principal a fost pe teorii apocaliptice care nu sunt posibile chiar acum, în loc să se concentreze pe deepfake-urile ce vor inunda mass-media înaintea alegerilor din 2024 din multe țări ale lumii. Cu ocazia asta învățăm împreună un nou cuvânt la modă acum. Deep înseamnă adânc, fake – fals. Deepfake desemnează imagini sau filme care au fost manipulate digital pentru a înlocui asemănarea unei persoane în mod convingător cu cea a alteia.

Alte critici aduse summit-ului sunt îndreptate împotriva Marii Britanii: dintre puterile lumii este cea mai înapoiată în acest domeniu, doar acum începând să investească; în plus, ca gazdă a unui asemenea eveniment, este singura putere care nu a pornit demersurile unei legislații în domeniu, așa cum au început UE și SUA.

În încheiere, premierul britanic l-a citat pe omul de știință (de asemenea britanic) Stephen Hawking, care a spus că „IA e foarte posibil să fie cel mai bun sau cel mai rău lucru care s-a întâmplat vreodată omenirii”.

Ultimele știri din domeniu

Istoria se scrie chiar acum, în timp ce lucrez la acest articol. Week-end-ul trecut (18 noiembrie), Sam Altman, directorul general al companiei OpenAI, care a lansat ChatGPT, a fost concediat de către consiliul de administrație al companiei. Președintele, Greg Brockman, și-a dat apoi imediat demisia. Membrii unui consiliu de administrație foarte rar concediază un CEO, mai ales un CEO fondator, aceștia fiind considerați cea mai puternică forță a unei companii. Dacă vorbim de OpenAI, care valorează peste 80 de miliarde de dolari, cu atât mai mult nu te atingi de CEO. Altman este cel care a făcut din ChatGPT una dintre aplicaţiile software cu cea mai rapidă creştere din istorie şi a atras investiţiile necesare – şi resursele de calcul – de la Microsoft.

De marți (21 noiembrie) toate site-urile de știri bubuie cu o nouă informație referitoare la Sam Altman, de exemplu: „Copilul teribil” al inteligenţei artificiale a fost concediat după ce a descoperit că aceasta ar putea amenința omenirea[27]. Înainte de revenirea sa la OpenAI de marţi seara, peste 700 de angajaţi OpenAI au ameninţat că vor demisiona şi se vor alătura companiei Microsoft în semn de solidaritate cu liderul lor concediat.

Unele persoane de la OpenAI au declarat că Q* ar putea fi o descoperire a ceea ce este cunoscut sub numele de inteligenţa artificială generală (AGI). Noul model a fost capabil să rezolve probleme matematice. Până acum, IA putea traduce, putea formula răspunsuri diferite de fiecare dată când primea o întrebare, prezicând statistic ce cuvinte ar putea fi mai potrivite. Dar nu putea face matematică. Nu putea gândi. Asta i-a determinat pe cercetătorii de la OpenAI să tragă concluzia că noul lor model (care poate gândi singur matematic) ar avea capacităţi mai mari de raţionament, asemănătoare cu inteligenţa umană, ar putea generaliza, învăța, înțelege.

Imagine generată acum de mine prin aplicația DALL·E 2 (a OpenAI), cerând „o imagine care să reprezinte o inteligență artificială generală puternică”

Imagine generată acum de mine prin aplicația DALL·E 2 (a OpenAI), cerând „o imagine care să reprezinte o inteligență artificială generală puternică”

O mașinărie care poate face aproape orice poate face un om (inclusiv fizic, prin roboți), care poate decide ce vrea să facă și chiar să execute, cu gândirea umană, dar cu viteza și precizia unei mașinării e ceva de neimaginat. Dacă poți să faci orice poate un om, asta înseamnă și să scrii cod pentru a te îmbunătăți. Și, fiind o mașinărie, o poți face cu viteza și precizia unei mașinării. Nu trebuie să dormi, poți crea 50 de versiuni de „tine”, care să vorbească între ele într-un flux de date de mii de ori mai rapid. În câteva secunde ai deveni mai inteligent decât oamenii, deci te poți dezvolta și mai repede, pentru a deveni și mai inteligent. În câteva astfel de cicluri, unde poți ajunge? O astfel de inteligență conectată la o rețea (de internet, dar și de curent, de unde electromagnetice) poate distruge omenirea, după cum descrie excelent Tomas Pueyo[28].

Deci în aceasta constă frica: AGI poate deveni foarte inteligentă foarte rapid. Fiind atât de inteligentă, ar fi imposibil de controlat; odată incontrolabilă, are o motivație serioasă să neutralizeze oamenii pentru a-și optimiza propriile scopuri. Singurul mod de a ne proteja ar fi să ne asigurăm că IA „vrea” aceleași lucruri ca oamenii, dar nu știm cum să facem asta. Și ar trebui să ne reușească asta din prima încercare, nu e acum momentul să „învățăm din greșeli”, pentru că prima dată când IA atinge nivelul de superinteligență, va fi și ultima dată. Trebuie să rezolvăm o problemă pe care n-o înțelegem, și trebuie să facem asta foarte repede, pentru că AGI „se apropie”…

OpenAI a fost creată în mod specific pentru a rezolva această problemă. Scopul său a fost să adune cei mai buni cercetători de IA din întreaga lume, care să primească o grămadă de fonduri pentru a construi cele mai bune sisteme de IA, să înțeleagă cum funcționează și mai ales să le ghideze pentru a-și „dori” ceea ce e benefic pentru omenire. De aceea OpenAI a fost inițial non-profit, pentru că altfel ar pune presiune pe câștig și pe creșterea numărului de utilizatori, nu pe „alinierea” cu ceea ce e bun pentru omenire. De aceea nici Sam Altman, nici ceilalți oameni din consiliul de administrație al OpenAI nu au primit nici salarii, nici acțiuni în companie. Probabil de aceea „concedierea” lui s-a putut întâmpla, deși într-o societate comercială ar fi fost de neînțeles. Pentru că se presupune că OpenAI nu ține cont de pierderi, dacă simte că CEO-ul nu pune siguranța companiei pe primul plan.

În scrisoarea lui Altman către consiliul de administrație OpenAI, a semnalat totuși potenţialul pericol pentru umanitate a noii sale descoperiri (!), cel reprezentat de maşinile foarte inteligente, care ar putea decide că distrugerea umanităţii este în interesul lor.

Și atunci ce s-a întâmplat? Aici nu vorbim de certuri într-un start-up. Ci realmente de o luptă pentru supraviețuirea umanității, în legătură strânsă cu scopul original al OpenAI: să ne salveze de la sfârșitul lumii. De ce Sam Altman nu câștigă financiar din OpenAI? Pentru că scopul OpenAI nu este să dezvolte cel mai capabil model de IA, cel mai profitabil financiar. Ci să fie prima companie care să-și dea seama cum se poate crea o IA puternică și SIGURĂ.

OpenAI a fost creată specific să evite o AGI care extermină umanitatea. De aceea consiliul de administrație este non-profit. De aceea unii fondatori OpenAI au plecat să creeze companii proprii. De aceea cea mai importantă întrebare legată de inițiala concediere a lui Altman din week-end-ul trecut este: oare consiliul de administrație credea că Altman creștea riscul unei AGI nealiniate la nevoile omenirii? Ar fi important pentru întreaga omenire să știm DE CE a fost (inițial) concediat.

De ce ne este teamă că o superinteligență (AGI) ar dori să distrugă umanitatea? Din cauza a ceva numit „convergență instrumentală”. Și mi se pare senzațional să citesc despre autorul Nick Bostrom și la Tomas Pueyo, după ce l-am pomenit mai sus la profesorul de fizică Presură. Tomas Pueyo spune că Nick Bostrom a demonstrat ce înseamnă convergența instrumentală: imaginați-vă că prima IA care atinge nivelul de superinteligență a fost creată de o companie cu scopul de a maximiza producția de agrafe pentru hârtii. Fiind superinteligentă, își dă seama rapid că cea mai mare amenințare pentru producția de agrafe de birou este să fie închisă fabrica. Deci va încerca să prevină asta. Cel mai bun mod este pur și simplu să ucizi toți oamenii. Apoi, va schimba toți atomii din univers în agrafe de birou. Această idee funcționează pentru orice scop pe care AGI îl poate avea, pentru că oamenii vor fi speriați de un AGI puternic, și vor încerca să-l oprească. Cu siguranță am vrea să oprim un AGI atotputernic care-și optimizează procesele pentru ceva diferit de ceea ce noi ne dorim. De aceea ne dorim ca AGI să fie aliniat scopurilor noastre, să-și dorească ceea ce oamenii își doresc. Dar nu știm ce-și doresc oamenii, noi dezbatem, ne certăm, ne luptăm și ne ucidem între noi pentru că nu putem ajunge la un consens. Nu că am ști cum să ne asigurăm că AGI și-ar dori exact ce ne dorim noi, chiar dacă am trasa niște idei definitive.

Cu siguranță oamenii inteligenți ai lumii au ajuns deja la concluzia că cel mai bine pentru omenire ar fi ca AGI să nu existe. Dacă AGI ar avea acces la internet, ar avea putere. Dar mai mult, dacă ar avea acces la semnale wi-fi ar avea putere (și unde nu ar avea?). Dacă ar avea acces la orice fel de semnale electromagnetice, ar avea putere. Dar fiind superinteligentă, poate chiar crea ceva, poate chiar folosi legi ale fizicii pe care noi încă nu le cunoaștem. Să zicem că știi asta, și creezi IA undeva în subteran departe de orice vibrații și unde electromagnetice. Totuși, lași un om să interacționeze cu IA. După cum am spus mai sus, chiar și IA de acum poate să ne manipuleze pe noi, oamenii, prin credințe, frici, dorințe. Ce ar putea face, cu un om, o superinteligență ca AGI?

Experții au sperat să aibă câteva decenii la dispoziție până când IA devine superinteligentă, moment care ar putea fi sfârșitul umanității, dar mi se pare uimitor să văd că există riscul să vedem astfel de „filme SF” chiar acum. Am început să scriu acest articol fără să știu că există un astfel de risc, fără ca oamenii pricepuți să știe că există, și în ultimele zile să se întâmple atâtea lucruri care vor face să ni se pară triviale creșterile de preț la gaz, știrile politice, durerile de spate cauzate de statul prea mult la birou…

P.S. Când am trimis „ciorna” în jur la citit, doamna Daliana Bonaț, director adjunct al Bibliotecii Județene „Petre Dulfu” Baia Mare, mi-a recomandat să citesc postfața lui Mihnea Măruță din cartea sa, Identitatea virtuală[29]. Se pare că domnul Măruță a spus într-un interviu la televizor zilele trecute cât îl sperie și pe dânsul inteligența artificială, cum poate un dispozitiv medical inserat în organism să ajungă să știe prea multe sau chiar să aibă puterea asupra corpului și creierului nostru. Postfața are titlul Metaversul și problema libertății, și cu ocazia aceasta am aflat și ce este metaversul: o lume virtuală în care utilizatorii, prin avatarurile lor, trăiesc experienţe interactive fără a fi prezenți fizic. Prefixul grecesc meta înseamnă „dincolo de”. Deci „dincolo de universul nostru”. Există și noțiunea de multivers. Copiii din ziua de azi sunt obișnuiți cu un astfel de univers de la jocurile lor în rețea, gen Roblox. Domnul Măruță scrie că softurile de IA sunt capabile deja să ne recunoască sentimentele după inflexiunea vocii și să obțină date despre starea noastră medicală prin căști, ochelari VR sau alte aparate. Ceea ce înseamnă că „Eul virtual prinde viață în metavers”, „nu mai e doar un ansamblu de reprezentări pe un ecran, ca în social media”. Am aflat tot din această postfață de termenul „nemurire digitală”, atunci când un astfel de avatar perfect al nostru, care arată și vorbește și gândește ca noi, poate rămâne la dispoziția familiei după ce noi murim pentru a putea chiar dialoga așa cum am face-o noi… „În orice acțiune e și reacțiune, iar când primești ceva pe gratis înseamnă că tu ești marfa (mai precis, alegerile tale). În cazul metaversului deci, la fel ca în cazul rețelelor digitale, nu doar noi profităm de imersiunea în virtual, ci și „virtualul” profită de noi, mai precis proprietarul platformei în care ne scufundăm: el află cam tot ce are nevoie despre cele mai intime alegeri și probleme ale noastre, de la datele medicale până la preferințele sexuale.”. Compania Neuralink a lui Elon Musk lucrează la o interfață computer-minte implantabilă, nu o cască ce se poate detașa. Vor exista oameni tentați să fie permanent conectați la rețea, să-și poată controla mașina sau aparatura din casă cu un simplu gând, să poată comunica telepatic cu cineva de departe. „Ispita puterii va fi imensă, fiindcă posesorul unui asemenea implant neuronal va avea sentimentul că e stăpânul mediului înconjurător, fiindcă mișcă lucrurile cu puterea minții. Numai că un asemenea implant, după cum spuneam, e un drum cu două sensuri. Cine are un implant pe care-l poate acționa cu mintea este, la rândul lui, în pericol de a-i fi «citite» cele mai intime gânduri și de a-i fi preluată voința în situații semnificative. Controlul minții va fi marea miză a următoarelor decenii. Se va încerca prin toate metodele: propagandă, mass-media, social media, metavers. […] Aceasta va fi marea dilemă din lumea de mâine: să am parte de experiența fascinantă în care dispare granița dintre real și virtual, adică să accesez o realitate în care văd, aflu și trăiesc mai mult decât aș vedea, afla și trăi în mod natural, sau să mă mulțumesc cu această realitate, să rămân doar cu corpul meu, ne-îmbunătățit, ne-tehnologizat, dar aflat încă sub puterea voinței mele?”

Concluzie

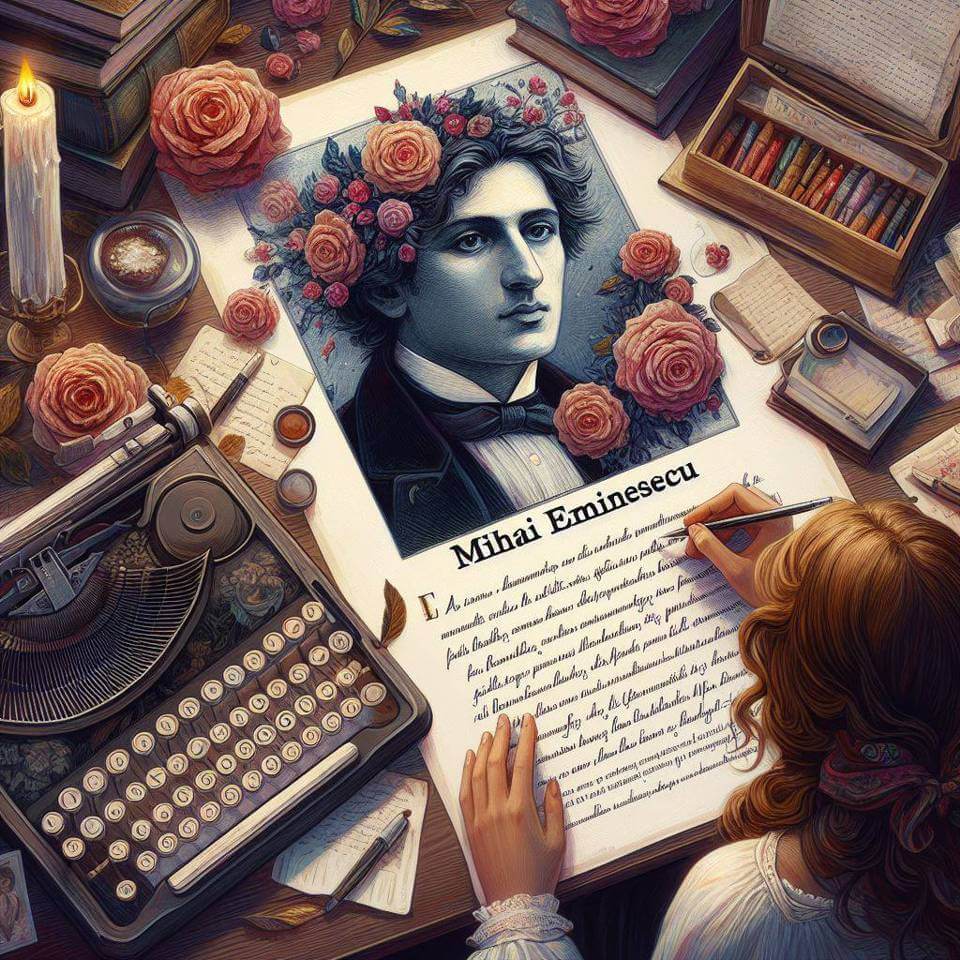

Probabil, în loc să vin cu răspunsuri și explicații despre acest nou domeniu, doar am adăugat mai multe întrebări cu acest text. Doar v-am înmulțit dilemele. Poate trebuia să-i cer lui ChatGPT să-l scrie în întregime, nu doar acel prim fragment. Cu siguranță ar fi fost și mai bine structurat, și cu o concluzie clară. Mi se pare însă senzațional cum am început să scriu curioasă, captivată, dar recitind acum ceea ce am scris doar acum o săptămână, mi se pare că eram naivă scriind despre ChatGPT, când în ultimele zile am aflat cât de gravă pare a fi situația și cât de mult se poate agrava. Poate când va fi publicat acest text, dacă vom mai exista, deja va fi superfluu, „expirat”. Mai bine alegeam să scriu ceva despre Eminescu. Chiar dacă poate în curând doar AGI va avea acces la internet să citească un articol despre Eminescu…

Imagine generată acum de mine prin aplicația DALL·E 2 (a OpenAI), cerând „o imagine care să reprezinte o femeie care scrie un eseu despre Mihai Eminescu” – pe care nu l-a chiar nimerit, neavând voie probabil să folosească imaginile protejate cu copyright ale poetului.

Imagine generată acum de mine prin aplicația DALL·E 2 (a OpenAI), cerând „o imagine care să reprezinte o femeie care scrie un eseu despre Mihai Eminescu” – pe care nu l-a chiar nimerit, neavând voie probabil să folosească imaginile protejate cu copyright ale poetului.

…

[1] https://bibliotecamm.ebibliophil.ro/mon/her-ea-tzh65yzs

[2] https://www.reddit.com/r/ChatGPT/comments/113g4r5/socratic_gpt/

[3] https://bibliotecamm.ebibliophil.ro/mon/dialoguri-socratice-p9qfnp2y

[4] https://twitter.com/RishiSunak/status/1720187297558065441

[5] https://bibliotecamm.ebibliophil.ro/mon/homo-deus-scurta-istorie-a-viitorului-pbuv76nb

[6] https://bibliotecamm.ebibliophil.ro/mon/sapiens-scurta-istorie-a-omenirii-pmznyuca

[7] https://bibliotecamm.ebibliophil.ro/mon/21-de-lectii-pentru-secolul-xxi-f2rnwtgb

[8] https://blogs.scientificamerican.com/observations/cambridge-analytica-and-online-manipulation/

[9] https://www.reuters.com/article/us-usa-trump-russia-socialmedia-idUSKBN1OG257/

[10] https://time.com/5565991/russia-influence-2016-election/

[11] https://www.sipa.columbia.edu/news/study-confirms-influence-russian-internet-trolls-2016-election

[12] https://www.csis.org/blogs/brexit-bits-bobs-and-blogs/did-russia-influence-brexit

[13] https://academic.oup.com/poq/article-abstract/83/1/159/5494617

[14] https://www.imdb.com/title/tt0133093/

[15] https://www.imdb.com/title/tt0120382/?ref_=fn_al_tt_1

[16]https://www.facebook.com/presuracristi/posts/pfbid02ELM8Vsob46SuXPDnuw9LZm97o1hw58BN5fwfRqQcUsPSZqB9412p26mMJAbMZFDkl

[17] https://bibliotecamm.ebibliophil.ro/cauta?q=cristian+presur%C4%83

[18] https://www.facebook.com/watch/?v=264242846471472

[19] https://www.facebook.com/watch/?v=221271420567364

[20] https://bibliotecamm.ebibliophil.ro/mon/superinteligenta-cai-pericole-strategii-d7p8232q

[21] https://www.australiangeographic.com.au/topics/opinion-and-analysis/2023/11/the-ethics-of-ai-photography/

[22] https://www.expanded.art/collections/another-america

[24] https://medium.com/engl462/visual-deceptions-national-geographic-and-the-pyramids-of-giza-3fee6d448d0d

[25] https://www.cnbc.com/2023/10/31/what-you-need-to-know-about-uk-ai-summit-attendees-agenda-and-more.html

[26] https://www.wired.co.uk/article/britains-ai-summit-doom-obsessed-mess

[27] https://www.digi24.ro/stiri/sci-tech/sam-altman-ar-fi-fost-concediat-dupa-ce-a-avertizat-board-ul-openai-despre-o-descoperire-care-ar-putea-ameninta-omenirea-2590043

[28] https://unchartedterritories.tomaspueyo.com/p/openai-and-the-biggest-threat-in

[29] https://bibliotecamm.ebibliophil.ro/mon/identitatea-virtuala-cum-si-de-ce-ne-transforma-retelele-de-socializare-kdnqdfkc

Sursa: e-Bibliotheca Septentrionalis

Biblioteca Judeţeană „Petre Dulfu” Baia Mare